What We Owe the Future (por William MacAskill) defiende el largoplacismo: la idea de que las personas de hoy tienen la obligación de crear un buen futuro para las generaciones sucesivas. Usando razonamiento filosófico, anécdotas históricas e investigaciones de las ciencias sociales, argumenta que el momento actual podría decidir si las personas del futuro vivirán vidas felices y prósperas o extraordinariamente miserables. Al considerar detenidamente nuestras acciones con respecto a cuestiones como la seguridad de la IA, la biotecnología y el bloqueo de valor, aumentamos las posibilidades de que las personas del futuro prosperen, tal como lo hacemos muchos de nosotros, ahora, gracias a personas del pasado.

El largoplacismo, en pocas palabras, es una filosofía que dice que las personas del futuro merecen nuestra consideración, que podrían ser muchas y que podemos mejorar sus vidas. Las personas del futuro están privadas de sus derechos: no pueden votar, cabildear, postularse para un cargo, escribir artículos o participar en protestas. Sin embargo, nuestras acciones los afectarán en gran medida. Si no tenemos cuidado, podríamos causar un bloqueo de valor negativo con el desarrollo de AGI, eliminar a la humanidad con un patógeno de bioingeniería o inhibir nuestra capacidad para responder a las amenazas existenciales al estancarnos tecnológicamente. Las mejores formas de salvaguardar el futuro son donar dinero a organizaciones benéficas altamente efectivas, participar en activismo político, fomentar el debate y tener hijos.

Del largoplacismo al largoplacimo radical

Williiam MacAskill es famoso por ser el filósofo de cabecera de Elon Musk y a quien todos deberíamos conocer. También, es profesor de filosofía de la Universidad de Oxford, se ha alzado como la más eminente voz del largoplacismo radical.

Ha empezado popularizarse un término entre los grandes círculos académicos: el longtermism o «largoplacismo radical». No en vano, llevaba el sello de Oxford. Venía firmado por dos filósofos, Hillary Graves y William MacAskill que anteponían como mayor prioridad frente a todos los problemas actuales la pretensión de garantizar un futuro a la humanidad.

¿Por qué el largoplacismo se centra en un futuro mejor?

¿Por qué debemos hacer todo lo posible para crear un futuro mejor? Un día soleado de primavera, estás caminando por un bosque vibrante. Mientras estás en el camino, accidentalmente dejas caer una botella de vidrio y se rompe. Supongamos que si dejas el vaso allí, un niño en algún momento se cortará gravemente con él. Tienes que decidir si limpiarlo. Al tomar la decisión, ¿importa cuándo exactamente el niño se lesionará? Si es dentro de una semana, una década o incluso un siglo, ¿cambia de opinión? Por supuesto que no. Un niño herido es un niño herido, sin importar cuándo esté herido.

Como muestra este simple experimento mental, las personas del futuro cuentan. Son personas, personas que tendrán dolor, alegría y sueños, al igual que el resto de nosotros. La única diferencia es que todavía no existen.

Esta es una de las ideas detrás del longtermismo : la idea de que las personas del futuro merecen nuestra consideración y nuestro esfuerzo.

¿Qué tipo de sociedad tiene en cuenta el largoplacismo?

¿Por qué importan las personas del futuro? ¿Qué harías si supieras que vas a tener que vivir la vida plena de cada persona en el futuro, desde su nacimiento hasta su muerte, sin importar cuán bueno o malo sea? ¿Te gustaría que, en el presente, redujéramos las emisiones de carbono para aumentar la calidad de tu vida? ¿Quieres que tengamos cuidado con las nuevas tecnologías? ¿Le gustaría que prestemos atención a cómo nuestras acciones de hoy impactan las condiciones del mañana?

Su respuesta a todas estas preguntas es probablemente «sí». Por supuesto que querrá que hagamos todo lo posible para crear un buen futuro para usted.

Después de todo, podría haber muchas personas en el futuro. Y según el largoplacismo, tenemos tanto la obligación como la capacidad de mejorar sus vidas.

La cantidad de personas futuras es relevante por una simple razón. Si te enfrentas a salvar a una o diez personas de un edificio en llamas, en igualdad de condiciones, deberías salvar a diez.

En el caso de la humanidad, la esperanza de vida de nuestra especie podría ser vertiginosamente larga. Si sobrevivimos hasta que la Tierra deje de ser habitable, en cientos de millones de años, podría haber un millón de personas en el futuro viviendo por cada persona viva hoy.

Todas esas vidas podrían ser prósperas o miserables, y tenemos influencia sobre el resultado. Colectivamente, como lo han demostrado los últimos doscientos años de historia, tenemos el poder de mejorar la esperanza de vida, reducir la pobreza, aumentar la alfabetización e influir en todo tipo de otras tendencias positivas. Por otro lado, también podemos crear muy malos resultados, como los regímenes totalitarios que surgieron en el siglo XX.

Por supuesto, así como nuestro futuro podría ser mucho más largo, también podría ser mucho más corto, si causamos nuestra propia extinción. Evitar ese resultado es una gran parte de nuestra responsabilidad, y hablaremos mucho de ello en las próximas secciones.

¿Qué moral y qué ética están detrás de la idea de largoplacismo?

¿Es inevitable el progreso moral? En el mundo de hoy, parece obvio que la esclavitud es abominable e inaceptable. Sin embargo, se practicó en la mayoría de las culturas, en la mayoría de los lugares, en la mayoría de los tiempos a lo largo de la historia.

Dado esto, la abolición de la esclavitud es en realidad bastante misteriosa. Era históricamente ubicuo, económicamente rentable, había durado siglos y fue defendido por personas influyentes. Sin embargo, la esclavitud fue efectivamente abolida, primero por Gran Bretaña y luego por otros países. ¿Fue esto sólo el resultado inevitable del progreso moral?

El autor argumenta que muchos eventos y factores específicos probablemente hicieron más probable la abolición. Estos incluyen el activismo de un pequeño número de cuáqueros, un grupo religioso de los siglos XVIII y XIX. La primera organización en la historia en llevar a cabo una campaña de abolición, su activismo inspiró a una generación de influyentes abolicionistas británicos.

Visto de esta manera, el abolicionismo se produjo en un momento crucial en el que se alinearon múltiples piezas del rompecabezas moral. Las creencias morales del mundo fácilmente podrían haber sido muy diferentes a las que conocemos hoy, y la esclavitud aún podría haber existido en todo el mundo.

Desde una perspectiva a largo plazo, cambiar los valores de la sociedad es increíblemente importante. Más específicamente, es importante poder cambiarlos.

Los valores pueden ser muy persistentes. Para ver esto, solo mire las ventas de Biblias. A pesar de haber sido escrito hace más de dos mil años, es el libro más vendido cada año, seguido del Corán. Estos libros aún influyen en innumerables resultados políticos en todo el mundo.

Debido a que los valores pueden ser tan persistentes, queremos evitar el bloqueo de valores: cualquier evento que provoque que un solo sistema de valores persista durante un tiempo extremadamente largo. Si el bloqueo de valores ocurriera a escala global, la bondad o maldad del futuro estaría determinada en gran medida por los valores que se bloquearon. Imagínese si la esclavitud hubiera sido parte de un sistema de valores bloqueados.

Afortunadamente, el estado actual del universo moral se parece mucho al vidrio fundido. En su estado caliente y altamente maleable, diferentes puntos de vista morales pueden competir para alterar e influir en la forma final. Sin embargo, los avances tecnológicos podrían acabar con esto, como veremos a continuación.

¿Qué entiende el largoplacismo como un futuro mejor?

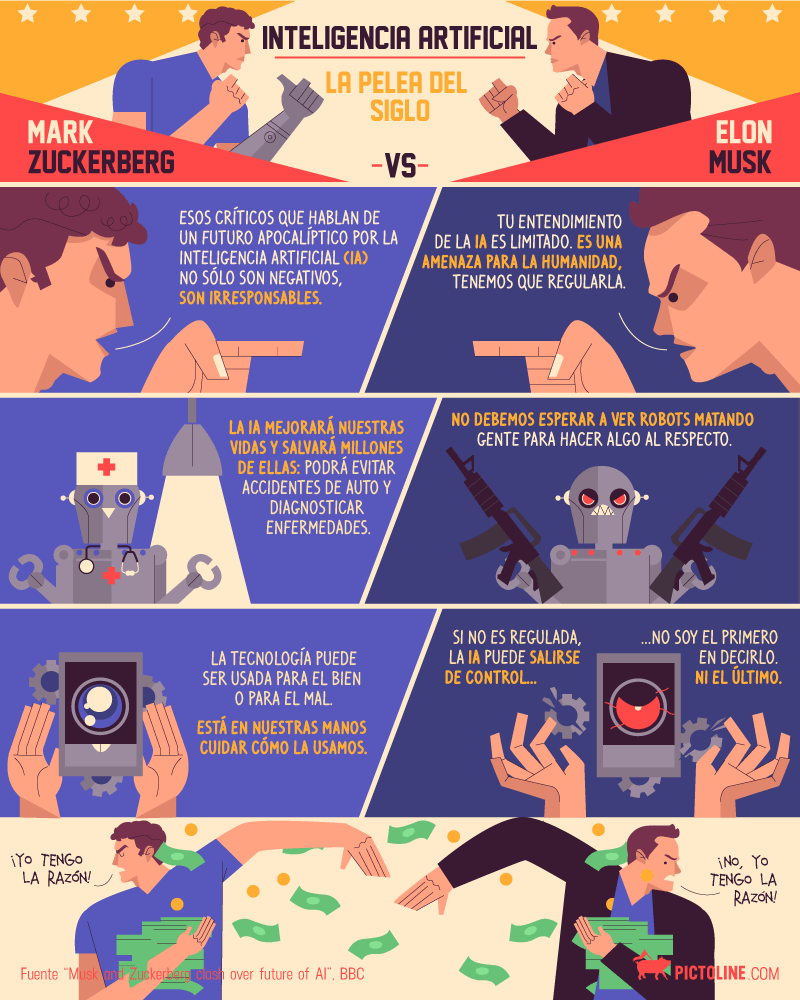

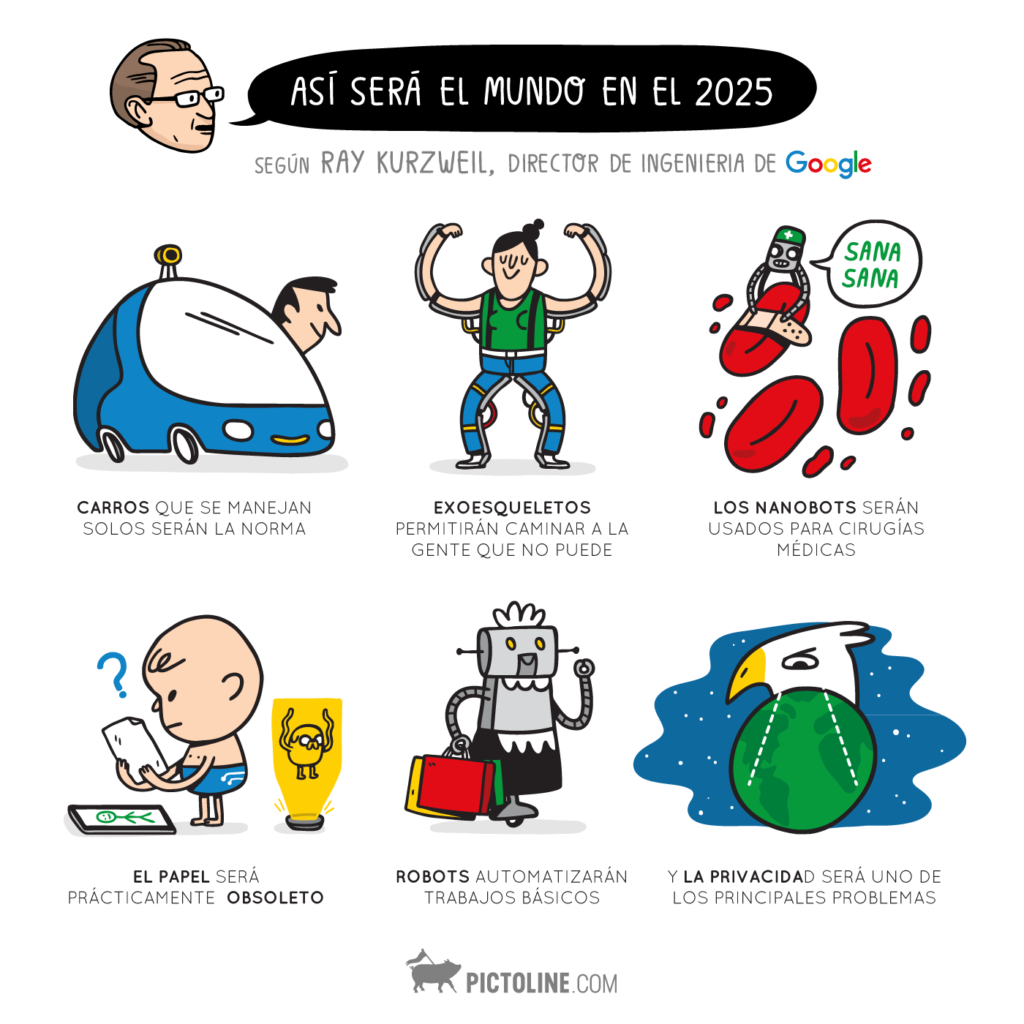

¿Cómo podemos hacer que el futuro sea mejor? Al pensar en el potencial de bloqueo de valor, una tecnología es particularmente preocupante. Eso es inteligencia general artificial, o AGI: un sistema que puede aprender y realizar una amplia gama de tareas al menos al mismo nivel que los humanos.

AGI hace que el bloqueo de valor sea una posibilidad por dos razones. En primer lugar, AGI podría potencialmente acelerar en gran medida tanto el crecimiento tecnológico como el económico. Si un país produjera un número cada vez mayor de trabajadores de IA, su economía podría crecer indefinidamente. En segundo lugar, AGI es potencialmente inmortal: el software se replica fácilmente y, una vez creado, en realidad no se puede destruir.

Usando esta tecnología, una persona, grupo o país podría crear agentes productivos, inteligentes y capacitados con objetivos estrechamente alineados con los suyos. El AGI entonces podría actuar y promover esos objetivos. Incluso podría codificarse para lograr un futuro muy específico, o usarse para emular indefinidamente la estructura cerebral de alguien. O todos estos a la vez.

Entonces, es posible que alguien pueda usar AGI para acabar con puntos de vista morales opuestos. ¿Querrían? Lamentablemente, mirando la historia, es posible que lo hagan. Históricamente, innumerables cruzadas religiosas y purgas ideológicas han buscado eliminar a personas con puntos de vista opuestos.

Por supuesto, no sabemos exactamente cuándo se desarrollará AGI. Las conjeturas entre los expertos en aprendizaje automático difieren enormemente, pero el pronóstico más sólido hasta la fecha lo ha realizado el analista Ajeya Cotra. Según su investigación, Contra supone que hay más del 10 por ciento de posibilidades de que se desarrolle AGI para 2036 y un 50 por ciento de posibilidades para 2050.

Incluso si AGI está a siglos de distancia, aún deberíamos considerar el bloqueo de valores, porque cualquier cosa que suceda en el tiempo intermedio podría afectar qué valores finalmente se bloquean. Si un sistema de valores es capaz de afianzarse globalmente, habría poca presión para que cambie con el tiempo. Sus puntos de vista podrían persistir durante miles de años. Con AGI, podrían persistir para siempre.

Dado esto, deberíamos aspirar a un mundo moralmente exploratorio, uno en el que las normas e instituciones que son moralmente mejores son las que tienen más probabilidades de ganar con el tiempo. Esto nos permitirá finalmente converger en la mejor sociedad posible.

Además, debemos favorecer el experimentalismo político. Una forma de hacerlo es mediante el desarrollo de ciudades chárter: comunidades autónomas que operan bajo leyes diferentes a las de sus países vecinos. Podríamos tener ciudades chárter basadas en el marxismo, el ambientalismo, el comunitarismo anarquista, lo que sea. Estos podrían usarse para determinar empíricamente qué conjuntos de valores generan la mejor sociedad.

Además del bloqueo del valor, ¿de qué otra manera podría terminar o colapsar la civilización? Discutiremos eso a continuación.

¿El largoplacismo podría frenar la extinción humana?

¿Cómo podríamos causar la extinción humana o el colapso de una civilización? En 1994, un cometa llamado Shoemaker-Levy 9 se estrelló contra el planeta Júpiter. Lo hizo con la fuerza de trescientos mil millones de toneladas de TNT, dejando una cicatriz literalmente del tamaño de la Tierra.

Los científicos habían estado advirtiendo sobre los peligros de los impactos de asteroides durante años. Por lo general, se reían de ellos, hasta el accidente de Júpiter. Después de eso, el interés público y la defensa de la comunidad científica aumentaron hasta que el Congreso tomó medidas. En 1998, lanzó la iniciativa Spaceguard, que encargó a la NASA encontrar el 90 por ciento de todos los asteroides y cometas cercanos a la Tierra de más de un kilómetro en una década. La iniciativa fue un éxito: la NASA ha encontrado más del 98 por ciento de los cuerpos astrales que podrían amenazar nuestra extinción. Nuestro riesgo de ser golpeado por un asteroide es cien veces menor que antes de Spaceguard.

Este ejemplo muestra que la humanidad tiene una capacidad real para mitigar las amenazas existenciales, siempre que las tomemos en serio. Actualmente, existen riesgos mucho mayores que los asteroides, y debemos enfrentar el desafío de enfrentarlos.

Uno de ellos es el riesgo de una pandemia diseñada, en otras palabras, el brote de una enfermedad que nosotros mismos diseñamos usando biotecnología. Se pueden crear patógenos modificados para que tengan combinaciones peligrosas de características: piense en algo tan letal como el ébola y tan contagioso como el sarampión. Otros riesgos provienen del hecho de que los nuevos patógenos podrían ser replicados fácilmente por personas normales en el hogar, y que los laboratorios que realizan trabajos biotecnológicos tienen estándares de seguridad preocupantemente laxos. Las fugas de laboratorio confirmadas ya han provocado brotes de ántrax, viruela, ébola y más.

Según varias estimaciones, la probabilidad de una pandemia diseñada a nivel de extinción este siglo es de entre 0,6 y 3 por ciento. Pero la extinción no es el único resultado que debería preocuparnos.

¿Podríamos recuperarnos si el 99 por ciento de las personas muriera a causa de una pandemia o una guerra nuclear? Hay alguna razón para pensar que lo haríamos. Para empezar, incluso si la mayoría de la gente muriera, la infraestructura física y las máquinas seguirían siendo utilizables en gran medida, al igual que las bibliotecas y los archivos digitales que contienen la mayor parte de nuestro conocimiento.

Sin embargo, podrían surgir complicaciones si no dejamos suficientes reservas de combustibles fósiles en el suelo. Esto se debe a que, históricamente, los combustibles fósiles parecen críticos para la industrialización. Cuando un país comienza a industrializarse, casi siempre quema mucho carbón primero y luego cambia a petróleo y gas. El agotamiento de los combustibles fósiles podría obstaculizar seriamente nuestra capacidad para recuperarnos de un colapso.

Es posible que podamos obtener algo de electricidad de los parques solares y eólicos restantes, pero estos se degradan en solo unas pocas décadas. Crear nuevos sería muy difícil sin la ayuda de cadenas de suministro internacionales avanzadas. Además, la energía solar y eólica no pueden proporcionar el calor de alta temperatura necesario para fabricar cemento, acero, ladrillo y vidrio. Baste decir que cuanto más agotemos nuestros recursos de combustibles fósiles, peor estaremos.

¿Cuáles son las reglas generales del largoplacismo?

¿Cómo podemos salvaguardar el futuro? Ahora que hemos cubierto los muchos malos caminos que podría tomar la civilización, probablemente se esté preguntando cómo puede ayudar a reducir el riesgo existencial.

En general, algunas reglas generales clave pueden ayudarnos a guiarnos en nuestros esfuerzos para influir en el futuro a largo plazo. La primera es tomar acciones que sean sólidamente buenas o que esté bastante seguro de que son buenas. La promoción de la innovación en tecnología limpia es un gran ejemplo que se ajusta a esta regla. Ayuda a mantener los combustibles fósiles bajo tierra, disminuye el impacto del cambio climático, promueve el progreso tecnológico y reduce el número de muertes por la contaminación del aire.

La segunda regla general para influir en el futuro es aumentar la cantidad de opciones que se le abren. Por ejemplo, ciertas trayectorias profesionales abren más oportunidades que otras. Un doctorado en economía o estadística te dará más opciones que, digamos, uno en filosofía.

Finalmente, la tercera regla general es seguir aprendiendo más. Individual y socialmente, siempre podemos continuar construyendo nuestro conocimiento de diferentes causas y temas importantes.

Ahora que tiene pautas generales para mejorar el mundo, debe decidir en qué problema específico quiere enfocarse. Aquí, priorizar es fundamental. Como muchas personas, es posible que desee elegir un problema que esté cerca de su corazón, tal vez porque le afecta a usted oa un ser querido. Sin embargo, esa causa podría no tener un alto impacto global. Las áreas de causa de mayor impacto son aquellas de las que hemos hablado en estos resúmenes: bloqueo de valor, AGI, biotecnología, cambio climático y estancamiento tecnológico.

Una vez que haya elegido el problema que cree que es más apremiante, es hora de actuar. Nuevamente, muchas personas no hacen esto de la manera más óptima. Por ejemplo, cuando las personas deciden promover el bienestar animal, muchas de ellas se vuelven vegetarianas de inmediato, tal como lo hizo el autor cuando tenía 18 años.

Aunque este tipo de acción personal es comprensible, los efectos son bastante minúsculos. Ser vegetariano cuando eres joven reduce tu huella de carbono total de por vida en una décima parte, o alrededor de sesenta y cuatro toneladas de carbono durante ochenta años. Compare eso con una donación única de $ 3,000 a Clean Air Task Force. Las estimaciones sugieren que tal donación reduciría las emisiones de dióxido de carbono del mundo en tres mil toneladas por año, exponencialmente más que ser vegetariano toda la vida.

Además de la donación de dinero, otra acción de alto impacto es el activismo político, cuya forma más sencilla es votar. Aunque la posibilidad de que su voto específico o su trabajo en pro de una causa marque una diferencia apreciable, el retorno puede ser muy alto si su campaña tiene éxito.

Otra acción impactante es difundir buenas ideas entre tu familia y amigos. La discusión entre amigos es una excelente manera de aumentar la participación política y puede motivar a las personas a trabajar en temas importantes.

La decisión final de alto impacto es tener hijos. Sí, es cierto que sus hijos producirán emisiones de carbono. Pero también harán muchas cosas buenas, como contribuir a la sociedad, innovar y abogar por el cambio político.

Tener más hijos también reduce el riesgo de que nos estanquemos tecnológicamente. El estancamiento es un gran riesgo porque podríamos desarrollar potentes herramientas destructivas antes de que tengamos formas de defendernos de ellas. Es posible que estemos entrando en un estado insostenible en el que somos capaces de bioingeniería de patógenos que podrían acabar con nosotros sin una forma de mitigar los riesgos.

Además, a medida que avanzamos tecnológicamente, tendemos a elegir la fruta madura: la tecnología más fácil de desarrollar. Con el tiempo, encontrar inventos igualmente importantes se vuelve cada vez más difícil. Hasta ahora, hemos abordado el problema simplemente aumentando el número de investigadores, ingenieros e inventores. Pero esa tendencia no puede continuar. La caída de las tasas de fertilidad significa que la población mundial se estancará en 2100 y luego disminuirá exponencialmente, según datos de la ONU. Si la tasa mundial de fertilidad cae a 1,5 hijos por mujer – la tasa actual en Europa–, la población mundial se reducirá de diez mil millones a menos de cien millones en 500 años.

Independientemente de lo que elija hacer para afectar el futuro, recuerde una cosa: una persona puede marcar la diferencia. Todo movimiento social y político a lo largo de la historia fue el resultado de combinaciones de esfuerzos individuales. Tú – nosotros – podemos ayudar a dirigir el futuro hacia una mejor trayectoria, para todas las personas futuras que aún no han nacido.

El largoplacismo y el futuro profesional

Considere cuidadosamente su carrera. La persona promedio pasa 80.000 horas en el trabajo a lo largo de su vida. Sin embargo, muchas personas encuentran que sus trabajos no son satisfactorios ni impactantes. En lugar de quedarnos atascados, deberíamos tratar nuestras carreras como científicos que prueban una hipótesis. Deberíamos pasar mucho tiempo investigando nuestras opciones, adivinando cuál es el mejor camino a largo plazo, probándolo durante un par de años, actualizando nuestra suposición y repitiendo según sea necesario. Después de todo, elegir una carrera es una de las decisiones de mayor impacto que puede tomar. Trátelo como un proceso iterativo en el que se mueve constantemente hacia la mejor opción para usted y el mundo.