Actualizado el miércoles, 12 julio, 2023

Cuando la carrera hacia las elecciones legislativas de noviembre comienza a ganar vértigo, Facebook reveló que removió 32 páginas y cuentas de su plataforma y de Instagram que estaban destinadas a crear una nueva campaña de desinformación y polarización en Estados Unidos similar a la de 2016. En aquella ocasión, en el Congreso, los legisladores demócratas apuntaron como culpable a Rusia.

«Cada día hay más evidencia de que el Kremlin continúa explotando plataformas como Facebook para sembrar la división y diseminar la desinformación»

Mark Warner, senador demócrata

Los medios que difunden Fake News también en España

«Últimamente veo que se comparte más de la cuenta noticias de CASOAISLADO, HAYNOTICIA, MEDITERRANEODIGITAL, 25MINUTOS, ELMATINAL…

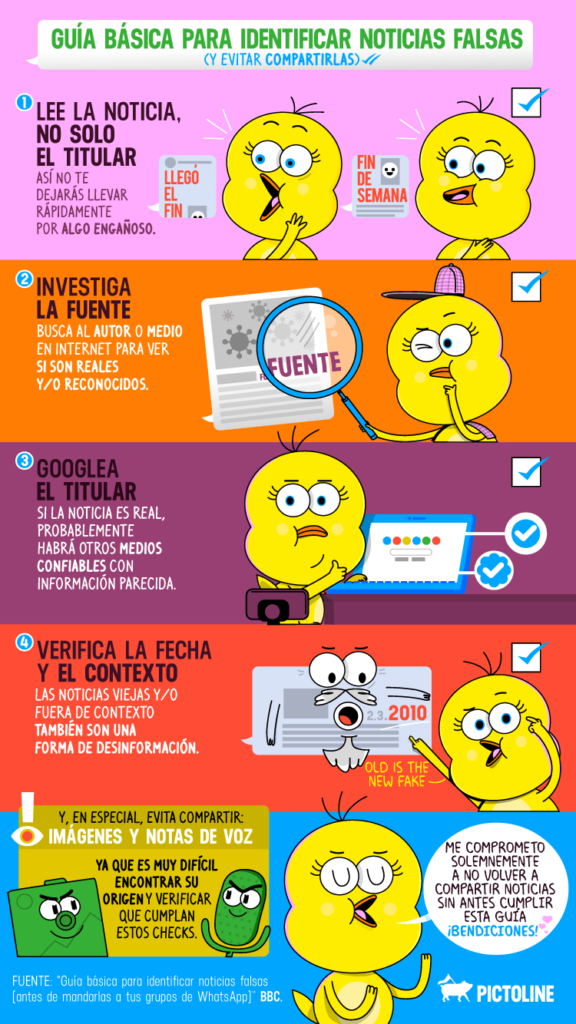

Te aconsejo que no compartas más este tipo de noticias, por algo muy sencillo, son NOTICIAS FALSAS. Son webs que venden el lema «la información que no te contarán otros medios». Pues tienen razón en ese sentido, porque el resto de medios CORROBORAN la información o no dan unos datos por buenos a la primera de cambio.

Te propongo un juego, cuando veas en internet una información que te sorprenda y quieras compartirla, búscala en otros medios. COMPARA. Por suerte, España disfruta de una amplia variedad de radios, televisiones y periódicos, tanto locales como nacionales. Si no aparece en ningún medio más, no estás ante una exclusiva, estás ante una mentira.

En el siglo XXI es muy difícil tener una exclusiva entre tus manos, en una sociedad donde la información corre como la pólvora. Si sólo te lo cuentan a ti, huye, es mentira.

Por eso, cuando compartes este tipo de información estás dejando patente tu incultura digital, tu pasividad a la hora de informarte y lo fácilmente manejable que eres»

Las grandes firmas de Silicon Valley (Google-YouTube, Facebook-Whatsapp, Twitter) están preocupadas. Las elecciones de 2016 y el Brexit mostraron que las plataformas eran un instrumento de movilización política, polarización y desinformación inusitado. Las elecciones del 2020 no solo han confirmado esa tendencia sino que han amplificado de una manera monstruosa, cancerígena, el problema. Con hipocresía puritana, han intentado corregir algo la estrategia de la posverdad con pequeños mensajes añadidos a los tuits de Trump. Sabían, saben, que no sirven de mucho, como no sirven de nada los anuncios en las cajetillas de tabaco. Han despertado a un Frankenstein que ya no volverá a la casa del amo. Y ello por muchas causas que están en el corazón del modelo económico contemporáneo: las televisiones, prensa (papel y digital), las macroempresas de consumo y servicios y las plataformas de big data dependen unas de otras. Sin este entrelazamiento no funcionaría la economía mundial. Quienes escriben sobre el tema tienden a considerar la polarización como un subproducto y por ello infraestimar su poder, quizás porque los consensos fáciles también dan miedo, pero la realidad es mucho más siniestra: sin los algoritmos movilizadores de pasiones no funcionaría el sistema, al igual que las estrategias de distinción de las que dio cuenta Bourdieu necesitan pasiones de poder para su dinámica. Sin polarización no hay dispersión de mensajes, retuits,… etc. y sin ello no hay perfiles, no hay estructuraciones sociales y, al fina, no hay estrategias comerciales. La política parece ser ya una parte del sistema y de la misma dinámica. Todo empieza a recordar a la filosofía de la historia de Tolstoi cuando habla de los campesinos retirándose ante las tropas de Napoleón. Meter al genio en la botella de nuevo va a ser la difícil tarea de varias generaciones.

Por qué Donald Trump es presidente gracias a las Fake News

Puede parecer una locura, pero que Donald Trump sea presidente de los Estados Unidos en parte es culpa de Facebook. Os preguntaréis de qué forma ha podido ayudar esta red social a una campaña presidencial tan importante.

La respuesta es más sencilla de lo que parece: la culpa la tienen las denominadas fake news, es decir, esas noticias falsas que se propagaron como la pólvora en las redes sociales.

Después de todo este tiempo ccon Trump a la cabeza de Estados Unidos parece que por fin la empresa de Mark Zuckerberg ha reflexionado sobre lo ocurrido y entona el mea culpa.

Explicaciones desde el blog oficial de Facebook de sus fakenews

En una serie de publicaciones realizadas en el blog oficial de la compañía, los ejecutivos de Facebook asumen su responsabilidad en cuanto medio propagador de mentiras e insidias que pueden llegar a desestabilizar un Gobierno o decantar las elecciones en favor o en contra de un determinado candidato.

Facebook se exculpa de la manipulación electoral

La red social se defiende argumentando que no se trata de Facebook, sino del daño que internet puede hacer a una democracia que funcione de manera correcta. Esta nueva postura de Mark Zuckerberg dicta mucho de su reacción en 2016. Por aquel entonces, dijo que era un disparate pensar que su empresa hubiera influido en las elecciones que finalmente ganó Trump.

Que el CEO de esta red social haya matizado sus palabras dice mucho acerca de su influencia. Es más, la directora de política global de Facebook, Katie Harbath, no tuvo dudas a la hora de afirmar que su empresa influye en los estados, sobre todo en las elecciones. Recordemos que, en 2011, las redes sociales desempeñaron un papel fundamental en la Primavera Árabe en lugares como Túnez, donde se anunció como una tecnología para la liberación.

¿Un «me gusta» en Facebook puede cambiar el mundo?

La respuesta es simple: no. El slacktivismo denomina al llamado activismo de sillón. Se trata de una forma de realizar activismo en línea, sin abandonar las actividades habituales, por lo general interactuando en las redes sociales. Por eso también se suele hablar de activismo 2.0 o de clicktivismo.Pero este concepto se cambió tras las últimas elecciones en EE.UU. Las redes sociales hacen que sea más fácil tener voz en el gobierno: para debatir cuestiones, organizarse en torno a las causas y responsabilizar a los líderes. Nuestra percepción de la realidad se rompe por inculpa de las interferencias de noticias falsas provenientes del extranjero que Facebook debió haber reconocido más rápido y que tanto desestabilizó las elecciones.

Tu responsabilidad al compartir contenido en Facebook

En otro artículo firmado por el ejecutivo Samidh Chakrabarti se cuenta cómo Facebook ayuda a sus usuarios a estar informados sobre política y comparte información sobre los lugares donde se producen debates interesantes. Lo que nunca podrá lograr es controlar si lo que se habla es verdad o mentira.

Esta entrevista ha salido a la luz cuando Facebook ha tomado la decisión de cambiar el algoritmo con el que pretende potenciar el contenido que crean y comparten sus usuarios, dándole más relevancia que a las noticias de los medios. Con él, Zuckerberg potenciará los blogs serios o marginales, o cualquier fuente de noticias falsas, poniendo en clara relevancia la misma (mala) calidad. Y eso sí que es una amenaza para la democracia.

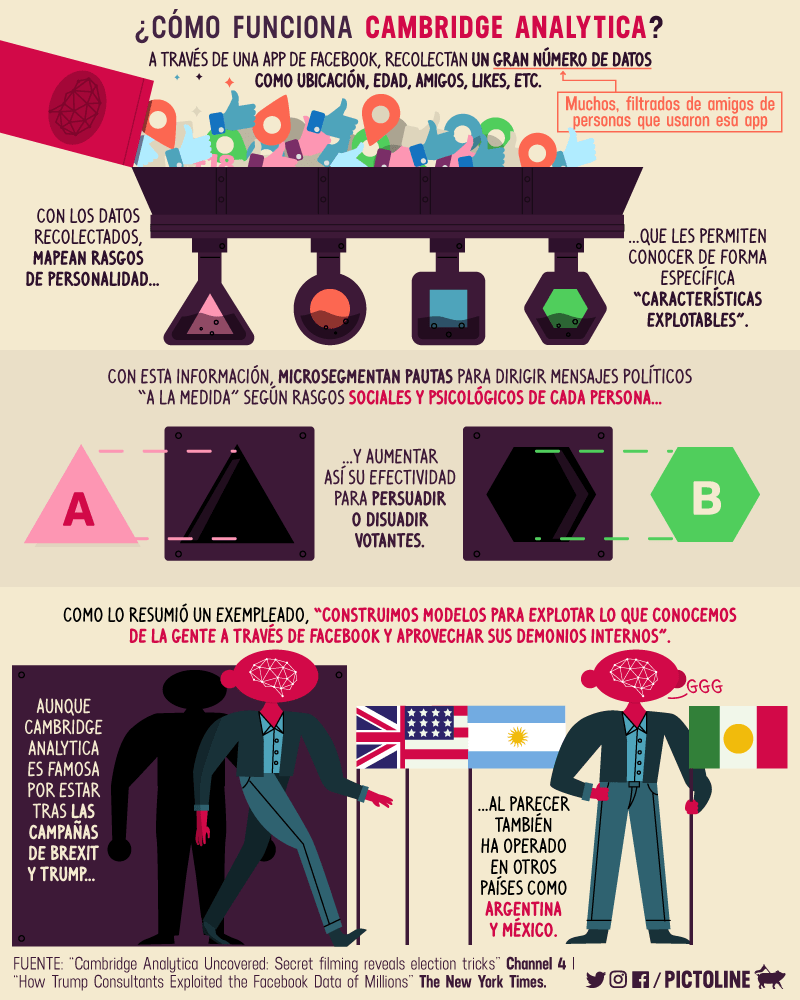

Cómo Cambridge Analytica diseñó una gran trampa electoral

Cambridge Analytica, empresa especializada en estudios de mercado, marketing digital y campañas de publicidad, fue contratada por la campaña de Donald Trump para las Elecciones Presidenciales de 2016 donde Trump derrotó contra todo pronóstico a Hillary Clinton gracias a una potente campaña online.

Según descubrieron los periodistas de The New York Times y The Observer (revista de The Guardian) gracias a Christopher Wylie, el ex trabajador de Cambridge Analytica , esta compañía se hizo con los datos de personales de 50 millones de usuarios de Facebook.

Gracias a un psicólogo de la Universidad de Cambridge llamado Aleksandr Kogan que creó una aplicación para estudiar la conducta de los usuarios de Facebook. Kogan consiguió permiso de Facebook para publicar su aplicación, que fue utilizada por unas 270.000 personas que creían que estaban participando en un estudio científico avalado por uno de los centros universitarios más prestigiosos del planeta. Pero mintió. Todos los que usaron su aplicación dieron permiso para no dar solo sus datos, sino también los de sus amigos. Así, el psicólogo pudo estudiar un total de 50 millones de personas.

Cambrige Analytica utilizó esos datos para ayudar a ganar Trump a través de anuncios y noticias hipersegmentados a través de Facebook para conseguir votos para el republicano.

A finales de 2015 Facebook averiguó lo ocurrido pero no decidió hacer ni admitir nada. Pero desde entonces, Mark Zuckerberg vende acciones de la compañía sin parar. ¿Supone esto un nuevo fraude. Si estaba operando en bolsa con información privilegiada, sí. Por ahora no hay pruebas, pero sí así fuera, Zuckerberg podría haber cometido un delito muy grave como inversor y que puede conllevarle una pena de hasta 20 años de prisión

Una mirada reveladora a un imperio de las redes sociales frentre a las democracias

Desde su fundación, Facebook ha generado controversias constantemente. El énfasis de Mark Zuckerberg en el crecimiento constante, los algoritmos de participación del usuario adictivos y las políticas de moderación laxas transformaron el sitio en un amplificador ideal para las opiniones extremistas y la discordia política. Si bien la compañía ha tomado medidas para frenar sus peores excesos, queda mucho trabajo por hacer. Si el imperio de las redes sociales mejorará sus servicios o desaparecerá, sigue siendo una pregunta abierta.

An Ugly Truth (2021) es una mirada crítica detrás de escena de Facebook. Esta investigación en profundidad revela la política y las personalidades que animan el ascenso y los posteriores errores de este controvertido gigante de las redes sociales.

El meteórico ascenso de Facebook fue una maravilla para la vista. En una mera década, este proyecto de dormitorio se expandió de la curiosidad de un pequeño campus a un imperio mundial de las redes sociales. Sin embargo, en los últimos años, el perfil de la empresa ha dado un giro más oscuro. La plataforma ahora se destaca por problemas de privacidad, desinformación y alianzas políticas inquietantes.

Estos consejos brindan una mirada en profundidad a las complejas maquinaciones que transformaron a Facebook en una de las empresas más controvertidas del mundo. Basado en informes rigurosos, este relato profundiza en cómo y por qué la plataforma se vio envuelta en escándalo tras escándalo. Repleto de hechos impactantes y verdades inquietantes, este examen oportuno muestra que la red social puede haber estado podrida desde el principio.

Descubrirás:

- por qué Zuckerberg terminó su primer proyecto, FaceMash;

- cómo Facebook interrumpió la vida en Myanmar; y

- por qué la empresa de tecnología emplea un «cazador de ratas».

Desde el principio, Zuckerberg valoró el compromiso por encima de la ética

8 de diciembre de 2015. Aparece un nuevo video en Facebook. En el clip corto, Donald Trump, entonces uno de los muchos aspirantes a la presidencia, está pronunciando un discurso apasionado. Él critica a los terroristas, a los inmigrantes, y luego pide una prohibición total y completa de la entrada de musulmanes a los Estados Unidos.

El clip se vuelve viral: en cuestión de horas se ha compartido 14.000 veces y acumula más de 100.000 me gusta. Para muchos empleados de Facebook, la retórica antimusulmana de Trump es un discurso de odio, una clara violación de los términos y condiciones del sitio. Quieren que se elimine del sitio.

Mark Zuckerberg no está de acuerdo. Después de reunirse con Joel Kaplan, vicepresidente de políticas públicas, Zuckerberg considera que el discurso es demasiado «digno de noticias» para eliminarlo. El clip queda para ser compartido aún más.

Incluso como estudiante de Harvard, el enfoque de Zuckerberg hacia las redes sociales causó controversia. De hecho, su primera plataforma, FaceMash, fue un blog de corta duración diseñado para clasificar el atractivo de sus compañeras de clase. Fue popular, pero no entre todos. El sitio recibió tantas críticas de grupos de estudiantes que Zuckerberg decidió desarrollar un proyecto nuevo y menos impactante: Thefacebook.

Lanzada en 2004, esta versión simple y temprana de lo que ahora llamamos Facebook solo tenía algunas características. Les permitió a los estudiantes configurar páginas personales, conectarse con otros usuarios y dejar mensajes entre ellos. Aún así, fue un gran éxito en los campus. En 2005, la plataforma tenía más de un millón de miembros y la mayoría iniciaba sesión más de cuatro veces al día. El éxito del sitio llevó a Zuckerberg a dejar Harvard, mudarse a Palo Alto y ejecutar Facebook como un esfuerzo de tiempo completo.

En estos primeros años, Facebook creció a pasos agigantados y el sitio fue considerado como la próxima gran novedad de Silicon Valley. La exageración fue tan fuerte que en 2006 Yahoo intentó comprar la empresa por mil millones de dólares. Zuckerberg rechazó la oferta. A pesar de ser tímido, torpe y joven, tenía planes ambiciosos para la empresa. En lugar de centrarse en las ganancias, apuntó al crecimiento. Continuamente presionó a su pequeño personal para que el sitio fuera más fascinante y entretenido.

En septiembre de 2006, Facebook lanzó News Feed. Esta nueva característica les dio a los usuarios un centro centralizado que mostraba la actividad de todos sus amigos. Al principio, el Feed era impopular: los usuarios se desanimaban por la sobrecarga de información y la repentina falta de privacidad. Sin embargo, las métricas de Facebook cuentan una historia diferente. El Feed hizo que las personas se conectaran por más tiempo y compartieran más, exactamente lo que quería Zuckerberg.

Sandberg transformó Facebook en una potencia publicitaria

Zuckerberg nunca fue un gran fanático de las conversaciones triviales. Sin embargo, en diciembre de 2007, todavía tenía el valor de asistir a una fiesta de Navidad organizada por un colega de Yahoo. Pero Zuckerberg no asistió a la alegría navideña. No, había alguien a quien quería conocer: una mujer llamada Sheryl Sandberg.

Sandberg ya tenía una excelente reputación como mujer de negocios astuta. Su impresionante currículum ostentaba títulos de Harvard y una temporada en el Banco Mundial. En ese momento, trabajaba como vicepresidenta de Google, quizás la principal empresa emergente de Silicon Valley.

En la fiesta, los dos hablaron de negocios durante más de una hora. Y, durante las próximas semanas, se reunieron varias veces más. En marzo de 2008, Facebook nombró con orgullo a Sandberg como su nuevo director de operaciones.

En muchos sentidos, Sandberg era exactamente lo que necesitaba Facebook. Si bien Zuckerberg estaba obsesionado con optimizar la tecnología del sitio y las características del usuario, estaba menos preocupado por otros detalles, como las ganancias. Por otro lado, Sandberg tenía una mentalidad empresarial. En Google, había convertido la pequeña operación publicitaria de la compañía en una empresa multimillonaria. Ahora, haría lo mismo con Facebook.

Como lo vio Sandberg, Facebook era especialmente adecuado para el mundo de la publicidad en línea. Mientras que Google vendía anuncios basados en los términos de búsqueda de los usuarios, Facebook tenía acceso a una variedad mucho más amplia de datos de los usuarios. Con esta información, la empresa podría publicar anuncios dirigidos según la actividad del usuario. No solo eso, la naturaleza interactiva del sitio alentó a los usuarios a responder directamente a las empresas y compartir anuncios con amigos.

Para aprovechar estas ventajas, Facebook tomó medidas para monetizar de manera eficiente los datos de sus usuarios. En 2009, introdujo el botón «Me gusta». Esta función permite a los usuarios reaccionar fácilmente a cualquier cosa publicada en el sitio. Luego, Facebook utilizó «me gusta» para ofrecer contenido dirigido y, lo que es más importante, recopilar las preferencias de los usuarios para venderlas a los anunciantes. El sitio también ajustó su configuración de privacidad. La nueva configuración era opaca y confusa y engañaba a los usuarios para que compartieran más información.

Los defensores de la privacidad como el Centro para la Democracia Digital tomaron nota de la creciente explotación de los datos de los usuarios por parte de Facebook. En diciembre de 2009, presentó una denuncia ante la Comisión Federal de Comercio, o FTC. La presentación resultó en que Facebook aceptara auditorías de privacidad periódicas, pero, en los próximos años, el gobierno hizo muy poco para monitorear o regular las acciones de la compañía.

Facebook intentó y no pudo permanecer políticamente neutral

Oficialmente, Sonya Ahuja era ingeniera. Pero, extraoficialmente, ella era «la cazadora de ratas». Su papel en Facebook era simple: cada vez que aparecía en la prensa una historia vergonzosa sobre la compañía, tenía que identificar y despedir a quien filtró la información.

Para el cazador de ratas, 2016 fue un año ajetreado. Gizmodo, un blog de tecnología popular, estaba publicando una serie de artículos incriminatorios sobre la disputa interna de Facebook. El informe alegaba que a medida que se calentaban las elecciones estadounidenses, las fuentes de noticias de los usuarios presentaban cada vez más historias falsas y un discurso de odio incendiario. Según Gizmodo, los empleados de Facebook querían frenar esta inquietante tendencia.

Por supuesto, todo el informe era cierto. En su búsqueda de dominación, Facebook se había convertido en un actor importante en el discurso político, y la compañía luchó con su nuevo rol.

Para 2016, millones de personas en los EE. UU. Y más allá usaban Facebook como su principal fuente de noticias e información. Esto fue bueno para los resultados de la empresa, pero vino con complicaciones. Por un lado, el algoritmo News Feed de Facebook favoreció las publicaciones con alto compromiso y, desafortunadamente, esas publicaciones generalmente eran incendiarias y sensacionalistas. Los usuarios a menudo veían contenido que confirmaba sus propios prejuicios, por muy falsos que fueran.

Para ajustar el tenor del sitio, la empresa introdujo «Temas de tendencia». Esta función permitió al equipo de contenido de Facebook seleccionar parcialmente lo que aparecía en los feeds de los usuarios. En mayo de 2016, Gizmodo publicó un artículo en el que afirmaba que el sitio utilizaba esta herramienta para suprimir publicaciones con puntos de vista de derecha. Como era de esperar, los medios conservadores se volvieron locos con la historia. Los republicanos ya sospechaban que el sitio tenía un sesgo liberal y esto parecía ser una prueba.

Para sofocar la reacción violenta, Zuckerberg se reunió con importantes figuras conservadoras como Glenn Beck de Blaze TV y Arthur Brooks del American Enterprise Institute. En estas reuniones, el fundador de Facebook reafirmó su compromiso con la libertad de expresión y afirmó que la empresa estaba haciendo todo lo posible para permanecer políticamente neutral. La estratagema solo funcionó parcialmente: los conservadores seguían sospechando y los liberales resintieron el apaciguamiento.

Mientras tanto, el equipo de inteligencia de amenazas de Facebook notó una nueva tendencia preocupante. Parecía que los piratas informáticos rusos estaban utilizando el sitio para publicar información errónea sobre los candidatos demócratas. Si bien esto no estaba técnicamente en contra de las reglas del sitio, algunos piratas informáticos también estaban distribuyendo correos electrónicos y otra información robada del Comité Nacional Demócrata. El equipo cerró algunas de estas cuentas deshonestas, pero el daño ya estaba hecho: muchas de las publicaciones se convirtieron en noticias nacionales.

Facebook evitó asumir la responsabilidad de la intromisión electoral generalizada

La improbable victoria electoral de Donald Trump tomó por sorpresa a gran parte del país, y Facebook no fue la excepción. En los días posteriores a las elecciones, Zuckerberg y su equipo se apresuraron a aceptar la nueva realidad.

Por un lado, la compañía tuvo que lidiar con la nueva administración, posiblemente hostil. Entonces, en un intento por afianzar los lazos con el nuevo presidente, la compañía contrató al exgerente de campaña de Trump, Corey Lewandowski, como consultor.

Para muchos empleados, la idea de trabajar con Trump era una idea surrealista y poco apetitosa. Sin embargo, en los próximos meses surgiría una idea aún más inquietante. A medida que Facebook investigaba su manejo de las elecciones, se hizo cada vez más claro que la compañía pudo haberlo ayudado a ponerlo en la Casa Blanca.

En los meses posteriores a las elecciones, Alex Stamos, jefe de ciberseguridad de Facebook, lanzó el Proyecto P. Esta investigación interna intentó determinar si actores externos habían utilizado el sitio como una herramienta de propaganda política. El equipo de Stamos revisó miles de anuncios políticos comprados durante las elecciones. Buscaron patrones que sugirieran campañas políticas coordinadas. Su búsqueda los llevó a la Agencia de Investigación de Internet, o IRA.

Ubicada en San Petersburgo, la IRA es una organización dedicada a impulsar los intereses políticos rusos. Durante la campaña de 2016, gastó más de $ 100,000 en anuncios de Facebook que empujaban posiciones extremas tanto a la izquierda como a la derecha. Los anuncios fueron muy apreciados y compartidos, llegando finalmente a 126 millones de estadounidenses. Es probable que esta operación, y otras similares, hayan influido en el ciclo de noticias y el resultado de las elecciones.

Al principio, Facebook intentó restar importancia a estos hallazgos: la compañía se mostró reacia a verse envuelta en un escándalo político. Aún así, en marzo de 2018 llegó un escándalo. The New York Times informó que Cambridge Analytica, una firma consultora del Reino Unido, había utilizado un agujero de seguridad para adquirir subrepticiamente datos de hasta 87 millones de usuarios de Facebook. Luego, la firma vendió los datos a la campaña de Trump para usarlos en el diseño de publicidad política dirigida.

La revelación reavivó las preocupaciones sobre las prácticas de privacidad de Facebook. El precio de las acciones de la compañía cayó un 10 por ciento y Zuckerberg fue llamado a testificar ante el Congreso. Sin embargo, durante la audiencia, muchos congresistas parecían analfabetos tecnológicamente y Zuckerberg evitó hábilmente cualquier declaración incriminatoria. Al final del día, el precio de las acciones de Facebook se había recuperado y parecía que la empresa evitaría cualquier responsabilidad real.

La moderación laxa del contenido de Facebook contribuyó a la violencia en la vida real

Es agosto de 2017. Sai Sitt Thway Aung, un soldado de la 99 División de Infantería Ligera del ejército birmano, enciende su teléfono y se conecta a Facebook. Con cuidado, escribe una nueva publicación. Describe su enojo contra los musulmanes y su deseo de expulsarlos de su país.

Aung tampoco está solo. En todo Myanmar, la gente publica y comparte mensajes negativos sobre los rohingya, la minoría musulmana del país. Pronto, el odio se convierte en violencia. En los meses siguientes, más de 24.000 rohingya mueren y cientos de miles más huyen a Bangladesh como refugiados.

Más tarde, un equipo de investigación de las Naciones Unidas estudia el conflicto. Consideran que Facebook jugó un «papel determinante» en la escalada de las tensiones raciales en la región hasta convertirse en un genocidio en toda regla.

En agosto de 2013, Facebook había acumulado más de mil millones de usuarios, un logro asombroso. Aún así, Zuckerberg tenía objetivos más elevados. Quería que su plataforma albergara miles de millones más. Para alcanzar esta cifra, la compañía necesitaba ir más allá de las naciones occidentales ricas donde ya era popular. Entonces, Zuckerberg lanzó «Next One Billion», un proyecto para expandir el acceso a Internet y Facebook a los países en desarrollo.

Si bien el proyecto logró ganar usuarios de Facebook, también tuvo consecuencias no deseadas. La compañía no anticipó cómo se usaría la plataforma en nuevos contextos. Tampoco contrató suficiente personal para moderar el sitio en los cientos de nuevos idiomas en los que se estaba utilizando. Entonces, cuando los budistas radicales anti-musulmanes comenzaron a difundir la retórica anti-rohingya, la compañía fue tomada por sorpresa, al menos al principio. .

Ya en 2014, los activistas de derechos humanos alertaron a Facebook sobre el peligroso discurso de odio en su plataforma. Matt Schissler, un activista en Myanmar, incluso viajó a la sede de la empresa para advertir al personal sobre la escalada de llamadas a la violencia. Pero sus súplicas cayeron en oídos sordos. A pesar de sus esfuerzos, Facebook hizo poco para frenar la retórica y el pueblo rohingya sufrió las consecuencias.

Esta tragedia evitable, junto con el escándalo de Cambridge Analytica y otros pasos en falso de alto perfil, estaban comenzando a erosionar la popularidad de Facebook. Facebook ya no era la empresa más popular de Silicon Valley y los nuevos talentos buscaban trabajo en otros lugares. Entonces, en julio de 2018, Zuckerberg hizo un anuncio. Se convertiría en un «CEO en tiempo de guerra» y desempeñaría un papel más importante en las operaciones diarias de la empresa. En el próximo año, intentaría volver a encarrilar a su empresa.

Facebook se ganó muchos enemigos con sus prácticas anticompetitivas

En mayo de 2019, Zuckerberg se había acostumbrado a la cobertura de prensa negativa. Pero, a pesar de su piel gruesa, un nuevo artículo de opinión en el New York Times se sintió como una puñalada por la espalda. Fue escrito por Chris Hughes, uno de los primeros cofundadores de Facebook. El título: «Es hora de romper Facebook».

Hughes había dejado Facebook una década antes y había fundado el Economic Security Project, un grupo de expertos progresista. En su artículo, argumentó que Facebook había crecido demasiado, demasiado rápido. Afirmó que la empresa aplastó a la competencia, jugó con rapidez y libertad con los datos de los usuarios y, en general, actuó como un monopolio peligroso.

Zuckerberg tenía razón al estar inquieto. Hughes fue solo el último de muchos políticos, académicos y defensores de los consumidores que pidieron al gobierno que desmantelara Facebook.

El crecimiento explosivo de Facebook fue parcialmente impulsado por una política firme de comprar competidores más pequeños. Para el momento del artículo de opinión de Hughes, la compañía había adquirido casi 70 operaciones más. La mayoría de estas compras cuestan menos de $ 100 millones, pero también hubo grandes fusiones. En 2012, Facebook compró la aplicación de fotos Instagram por mil millones de dólares. En 2014, pagó $ 19 mil millones para adquirir la aplicación de mensajería WhatsApp.

Estas compras le dieron a Facebook una cifra sin precedentes de 2.500 millones de usuarios en todo el mundo. También le dio a la empresa acceso a una cantidad insondable de datos de usuario. Si bien Zuckerberg originalmente prometió dejar que cada operación mantuviera una autonomía relativa, finalmente decidió fusionar los servicios. Si bien cada aplicación continuaría pareciendo separada, su infraestructura de back-end en realidad sería profundamente interdependiente.

Para los profesores de derecho Tim Wu y Scott Hemphill, la fusión fue simplemente una estrategia para dificultar las acciones antimonopolio. Al combinar cada servicio, Facebook podría afirmar que cualquier ruptura ordenada por el gobierno sería demasiado complicada. Aún así, la acción no cambió el panorama político. A medida que aumentaban las elecciones de 2020, políticos como Elizabeth Warren y Bernie Sanders hicieron de la regulación de Facebook un tema de conversación común.

Mientras tanto, Facebook siguió cometiendo errores políticos. Si bien Zuckerberg y Sandberg se jactaban de las nuevas políticas de moderación, el sitio continuó flaqueando. A lo largo de 2019, circularon videos polémicos de deepfake en la plataforma, incluido un video vergonzoso de la presidenta de la Cámara y aliada de Silicon Valley, Nancy Pelosi. Cuando Zuckerberg se negó a retirar el clip, Pelosi se volvió contra la empresa. De repente, Facebook tenía muy pocos amigos en DC.

Facebook intentó y fracasó en cambiar su marca como un bastión de la libertad de expresión

El verano de 2019 fue un momento ajetreado para Zuckerberg. A instancias de Joel Kaplan, Nick Clegg y otros expertos en políticas públicas de Facebook, el director ejecutivo pasó meses codeándose con expertos políticos. Se reunió con la senadora republicana Lindsay Graham, el experto de derecha Tucker Carlson y, finalmente, el propio presidente Trump.

La reunión con Trump, celebrada en la Oficina Oval por Diet Cokes, transcurrió sin problemas. Zuckerberg felicitó a Trump por su maravillosa presencia en las redes sociales. A su vez, Trump se entusiasmó con Zuckerberg. Después, incluso publicó un Tweet celebrando la ocasión.

Si bien la controvertida reunión molestó a muchos empleados de Facebook, Zuckerberg no pareció inmutarse. Después de todo, si quería proteger el futuro de Facebook, tenía que tener aliados en las altas esferas.

Al conocer a Trump, Zuckerberg quería cambiar la conversación sobre Facebook. Quería que el presidente, y los republicanos en general, vieran su negocio como un activo para Estados Unidos. Entonces, cuando se reunía con políticos, a menudo proclamaba que empresas como la suya servían como un valioso baluarte contra la creciente competencia de competidores chinos como WeChat y TikTok.

Sin embargo, esta no fue la única estrategia de Zuckerberg. También quería replantear la moderación laxa de Facebook como una virtud. En el período previo a la temporada de campaña de 2020, Facebook anunció que no verificaría ni moderaría ningún tipo de publicidad política. Casi de inmediato, la nueva política recibió una reacción violenta de los políticos, los grupos de defensa y la gente común preocupada por la desinformación que estropeaba otras elecciones.

Entonces, para evitar las críticas, Zuckerberg pronunció un discurso de alto perfil en el campus de la Universidad de Georgetown en Washington, DC. En el discurso, el CEO promocionó el compromiso de larga data de Facebook con la libertad de expresión. Afirmó falsamente que el sitio fue fundado para cultivar la discusión política sobre la guerra de Irak de 2003 e hizo extrañas comparaciones entre las publicaciones en línea y el Movimiento por los Derechos Civiles.

El evento fue criticado rotundamente por casi todos, incluida la Liga Antidifamación y la popular congresista Alexandria Ocasio-Cortez. En las semanas siguientes, Sandberg se vio obligado a defender la nueva posición de Zuckerberg en una entrevista con la periodista Katie Couric. A pesar de sus esfuerzos, no pudo defender mejor las nuevas políticas de Facebook. Después de años de errores, la gente estaba realmente cansada de los efectos negativos de la compañía, y aún faltaban más pruebas.

Varias crisis empujan a Facebook a reevaluar su absolutismo sobre la libertad de expresión

El presidente Trump está de nuevo en eso: está de pie en el podio fanfarroneando durante otra conferencia de prensa. Solo que esta vez, es abril de 2020 y COVID-19 está surgiendo en todo el mundo. El presidente, en una digresión característica, sugiere que la ingestión de desinfectantes domésticos podría curar el virus.

Por supuesto, en cuestión de minutos, el clip aparece en la página de Facebook de Trump. Técnicamente, la publicación viola el dictamen del sitio contra la desinformación médica. Desde el comienzo de la pandemia, la compañía ha estado más atenta a la supresión de rumores peligrosos. Sin embargo, ¿cómo debería manejar este? ¿Debería eliminar el puesto del presidente?

Una vez más, Zuckerberg y su equipo se inclinan por la libertad de expresión. La publicación permanece, desinformación y todo.

La primavera de 2020 marcó un cambio radical para la moderación del contenido en línea. La pandemia de COVID-19 y la protesta nacional a raíz del asesinato de George Floyd inició una nueva ola de retórica acalorada, y las plataformas estaban comenzando a responder. En mayo, Trump publicó un tuit en el que insinuaba que se debería disparar a los manifestantes. En una respuesta sin precedentes, Twitter etiquetó la publicación como peligrosa.

Aún así, Zuckerberg se negó a tomar ninguna medida. Los empleados de Facebook estaban indignados. Muchos participaron en una huelga digital y 33 empleados fundadores firmaron una carta abierta condenando a la empresa. En junio, los anunciantes también estaban hartos de la prensa negativa: las principales empresas como Verizon, Starbucks y Ford incluso organizaron un boicot del sitio durante un mes.

Trump no fue el único problema. La nueva función de grupo privado de Facebook también estaba causando estragos. Estos centros no moderados se habían convertido en pozos negros que gestaban discursos de odio, teorías de conspiración y organizaciones de milicias de derecha. Luego, el 6 de enero, una turba violenta irrumpió en el edificio del Capitolio en un intento de revertir las recientes elecciones. Los medios notaron rápidamente que muchos participantes pasaban mucho tiempo publicando en Facebook y organizándose en páginas grupales no moderadas.

Finalmente, la empresa cambió de rumbo. Facebook anunció una política más estricta contra las publicaciones peligrosas y suspendió la cuenta de Trump durante varias semanas. La compañía incluso instituyó la Junta de Supervisión de Facebook, un panel nuevo e independiente para dictaminar sobre cuestiones de contenido. Aparentemente, la junta proporcionará más supervisión, aunque los críticos alegan que es simplemente un movimiento para desplazar la responsabilidad de los ejecutivos de la empresa. Para Facebook, el futuro sigue siendo incierto.

La verdad oculta de Facebook según uno de sus primeros inversores

Facebook se ha convertido en una catástrofe: mantiene a la gente enganchada a sus pantallas, empujándonos hacia puntos de vista más extremos, pisoteando la privacidad personal e influyendo en las elecciones. Es hora de contraatacar y dejar de tratar los impactos negativos de Facebook en las personas y la sociedad como aceptables.

Zucked es la advertencia personal de uno de los primeros inversores de Facebook, Roger McNamee, sobre los peligros de la plataforma. Describe vívidamente cómo Facebook está dañando tanto la salud pública como la salud de nuestras democracias. Desde la manipulación de la opinión pública hasta la construcción de nuestra adicción a la tecnología, la imagen pintada en Zucked es la de un negocio desligado de la responsabilidad cívica o moral.

Roger McNamee ha sido inversionista en Silicon Valley durante más de tres décadas y fue un inversionista en etapa inicial tanto en Facebook como en Google. Su fondo más reciente, Elevation, fue cofundado con Bono de U2. Además de invertir, hace campaña para generar conciencia sobre los impactos negativos de las redes sociales.

Conozca la verdadera historia de Facebook y su impacto dañino en la sociedad

Facebook es una de las empresas más populares de la historia. Con 2200 millones de usuarios e ingresos que superaron los 40 000 millones de dólares en 2017, es todo un éxito. Pero más que ser popular y rentable, Facebook es influyente. En menos de dos décadas, se ha convertido en una parte crucial de la esfera pública, la plataforma en la que no solo nos comunicamos con nuestros amigos, sino que también leemos las noticias, intercambiamos opiniones y debatimos las noticias del día.

Pero la popularidad y la influencia de Facebook ocultan una realidad oscura: carece de valores morales o cívicos claros que lo guíen. Y en ausencia de una regulación efectiva, está dañando activamente a nuestra sociedad.

En estas claves sociológicas y políticas, aprenderás cómo Facebook utiliza técnicas de manipulación para mantenerlo enganchado y cómo un efecto secundario está polarizando el debate público. Estas claves muestran cómo Facebook prospera con la vigilancia, recopilando datos sobre usted para mantenerlo enganchado al sitio y aumentando su valor para sus anunciantes. Y llegará a comprender lo fácil que ha sido para actores externos como Rusia usar Facebook para influir en los usuarios de los Estados Unidos.

Aprenderás

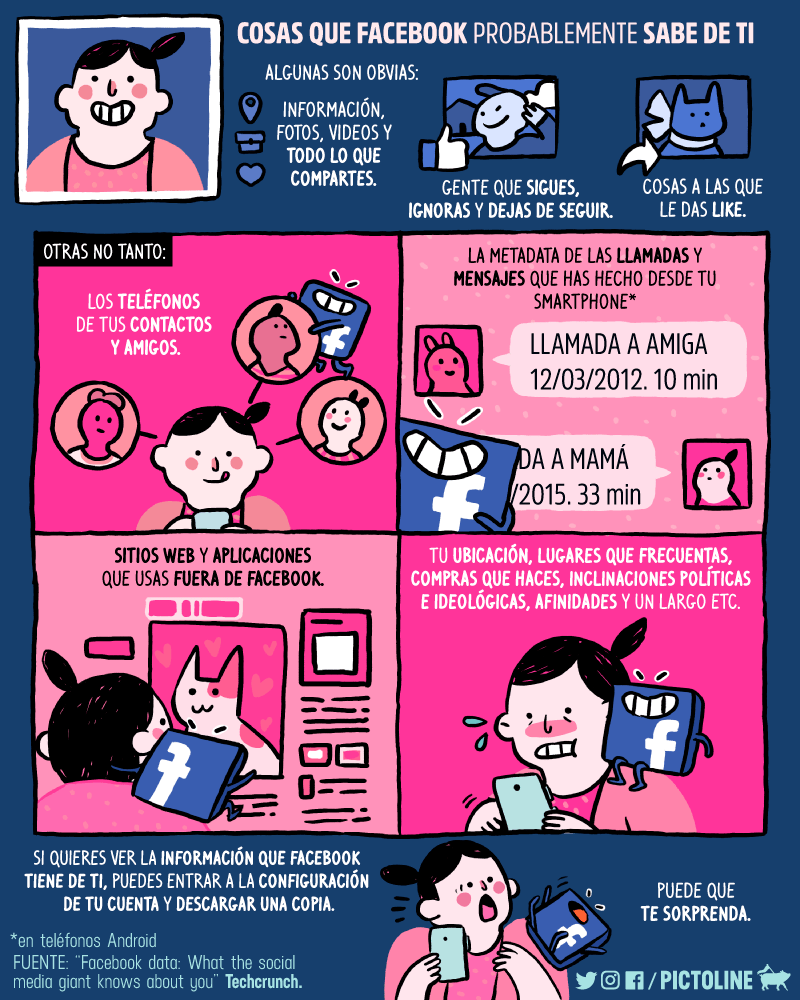

- cuántos datos tiene Facebook sobre ti;

- cómo Facebook ha ignorado persistentemente la privacidad de sus usuarios; y

- por qué no deberíamos tener nada que temer sobre la regulación de Facebook y otros gigantes tecnológicos.

Los cambios tecnológicos y económicos permitieron el crecimiento de Facebook y una peligrosa cultura interna

En el siglo XX, no había muchas empresas emergentes exitosas en Silicon Valley dirigidas por personas recién egresadas de la universidad. La ingeniería informática exitosa se basaba en la habilidad y la experiencia, y necesitaba superar las limitaciones del poder de procesamiento, el almacenamiento y la memoria limitados de la computadora. La necesidad de una infraestructura de hardware seria significaba que no cualquiera podía crear una empresa nueva y ser un éxito instantáneo.

Los desarrollos tecnológicos a finales del siglo XX y principios del XXI cambiaron fundamentalmente esto. Cuando Mark Zuckerberg inició Facebook en 2004, muchas de estas barreras para las nuevas empresas simplemente habían desaparecido. Los ingenieros pudieron crear un producto viable rápidamente, gracias a los componentes de software de código abierto como el navegador Mozilla. Y la aparición del almacenamiento en la nube significó que las nuevas empresas simplemente podían pagar una tarifa mensual por sus infraestructuras de red, en lugar de tener que construir algo costoso por sí mismas.

De repente, surgió el modelo lean start-up. Las empresas como Facebook ya no necesitaban trabajar lentamente hacia la perfección antes de lanzar un producto. Podrían construir rápidamente algo básico, enviarlo a los usuarios y actualizar desde allí. Así nació la famosa filosofía de Facebook de «muévete rápido y rompe cosas».

Esto también tuvo un profundo impacto en la cultura de empresas como Facebook. Un emprendedor como Zuckerberg ya no necesitaba un grupo grande y experimentado de ingenieros con una gran experiencia en sistemas para entregar un plan de negocios.

De hecho, sabemos que Zuckerberg no quería gente con experiencia. Los jóvenes sin experiencia, y la mayoría de las veces eran hombres, no solo eran más baratos, sino que podían amoldarse a su imagen, lo que hacía que la empresa fuera más fácil de administrar.

En los primeros años de Facebook, el propio Zuckerberg tenía una confianza resuelta, no solo en su plan de negocios, sino también en el objetivo evidentemente beneficioso de conectar el mundo. Y a medida que el número de usuarios de Facebook, y eventualmente la rentabilidad, se dispararon, ¿por qué alguien de su equipo lo cuestionaría? E incluso si quisieran, Zuckerberg había establecido las reglas de participación accionaria de Facebook para que tuviera un «voto de oro», lo que significa que la empresa siempre haría lo que él decidiera.

Para crecer lo más rápido posible, Facebook hizo todo lo posible para eliminar las fuentes de fricción: el producto sería gratuito y el negocio evitaría la regulación, evitando así la necesidad de transparencia en sus algoritmos que podría invitar a las críticas.

Desafortunadamente, si bien estas fueron las condiciones adecuadas para el crecimiento de una superestrella mundial, también fueron condiciones que generaron un desprecio por la privacidad, la seguridad y la responsabilidad cívica del usuario.

Facebook recopila agresivamente datos sobre sus usuarios y ha mostrado un flagrante desprecio por la privacidad de los usuarios

Ahora sabes un poco sobre Facebook. Pero, ¿qué tan bien te conoce Facebook?

Facebook tiene hasta 29.000 puntos de datos de cada uno de sus usuarios. Eso son 29,000 pequeñas cosas que sabe sobre tu vida, desde el hecho de que te gustan los videos de gatos hasta con los que has estado socializando recientemente.

Entonces, ¿de dónde obtiene Facebook esos datos?

Take Connect, un servicio iniciado en 2008, que permite a los usuarios iniciar sesión en sitios web de terceros a través de Facebook. A muchos usuarios les encanta la simplicidad de no tener que recordar innumerables contraseñas complicadas para otros sitios. Lo que la mayoría de los usuarios no se dan cuenta es que el servicio no solo los registra. También permite que Facebook los vigile en cualquier sitio o aplicación que haya utilizado el inicio de sesión. ¿Usar Connect para iniciar sesión en sitios web de noticias? Facebook sabe exactamente lo que estás leyendo.

O tomar fotos. A muchos de nosotros nos encanta etiquetar a nuestros amigos después de un día o una noche divertida. Puede pensar que es una manera fácil de compartir con sus amigos, pero para Facebook, está brindando una valiosa colección de información sobre su ubicación, sus actividades y sus conexiones sociales.

Ahora, si una empresa es tan codiciosa por sus datos personales, al menos esperaría que tratara esos datos con cuidado, ¿verdad? Desafortunadamente, desde los primeros días de Facebook, el negocio de Mark Zuckerberg ha mostrado un aparente desprecio por la privacidad de los datos.

De hecho, según Business Insider , después de que Zuckerberg reunió a sus primeros miles de usuarios, le envió un mensaje a un amigo para decirle que si alguna vez querían información sobre alguien en su universidad, solo tenían que preguntar. Ahora tenía miles de correos electrónicos, fotos y direcciones. La gente simplemente los había enviado, dijo el joven empresario. Eran, en sus palabras informadas, «tontos de mierda».

Desde entonces, ha persistido una actitud arrogante hacia la privacidad de los datos en Facebook. Por ejemplo, en 2018, los periodistas revelaron que Facebook había enviado materiales de marketing a los números de teléfono proporcionados por los usuarios para la autenticación de dos factores, una función de seguridad, a pesar de haber prometido no hacerlo.

Y en el mismo año, se reveló que Facebook simplemente había descargado los registros telefónicos, incluidas las llamadas y los mensajes de texto, de aquellos de sus usuarios que usaban teléfonos Android. Nuevamente, los usuarios en cuestión no tenían idea de que esto estaba sucediendo.

Facebook quiere tus datos por una razón: ganar más dinero al mantenerte en la plataforma por más tiempo y así hacer que su oferta para los anunciantes sea más valiosa. Echemos un vistazo a esto con más detalle.

Facebook utiliza la piratería mental para mantenerlo en línea el mayor tiempo posible y para aumentar sus ganancias.

Para las plataformas de redes sociales, el tiempo es dinero. Específicamente, su tiempo es su dinero. Porque cuanto más tiempo pases en Facebook, Twitter o Instagram, y más atención les des, más publicidad podrán vender.

Como resultado, captar y mantener su atención es la base del éxito comercial de Facebook. El negocio se ha vuelto mejor que nadie para entrar en tu cerebro.

Algunas de las técnicas que utiliza son sobre cómo muestra la información. Estos incluyen la reproducción automática de videos y una fuente interminable de información. Estos te mantienen enganchado al eliminar las señales normales para desconectarte. Puede llegar al final de un periódico, pero nunca al final de las noticias de Facebook.

Otras técnicas profundizan un poco más en la psicología humana, por ejemplo, explotando FOMO: el miedo a perderse algo. Intenta desactivar una cuenta de Facebook y verás no solo una pantalla de confirmación estándar, sino también las caras de tus mejores amigos, Tom y Jane, y las palabras «Tom y Jane te extrañarán».

Pero las técnicas más sofisticadas y siniestras que utiliza Facebook radican en el proceso de toma de decisiones de su inteligencia artificial, que decide qué mostrarte.

Cuando te desplazas por Facebook, podrías pensar que estás viendo una fuente de noticias simple. Pero no lo eres. Te enfrentas a una inteligencia artificial gigantesca que tiene enormes cantidades de datos sobre ti y te proporciona lo que cree que te mantendrá conectado con el sitio durante el mayor tiempo posible. Y la mala noticia para la sociedad es que eso a menudo significa contenido que apela a tus emociones más básicas.

Eso es porque desencadenar nuestras emociones básicas es lo que te mantiene comprometido. Joy funciona, razón por la cual los videos de gatos lindos son tan comunes. Pero, ¿qué funciona mejor? Emociones como el miedo y la ira.

Como resultado, Facebook tiende a empujarnos hacia el contenido que nos irrita porque los usuarios irritados consumen más contenido y lo comparten con más frecuencia. Por lo tanto, es menos probable que vea titulares tranquilos que describen eventos y es más probable que vea afirmaciones sensacionalistas en videos cortos e impactantes.

Y eso puede volverse peligroso. Particularmente cuando nos quedamos atrapados en una burbuja donde nuestra indignación, miedos u otras emociones son constantemente reforzadas por personas con puntos de vista similares. Ese es el peligro de la llamada burbuja de filtro.

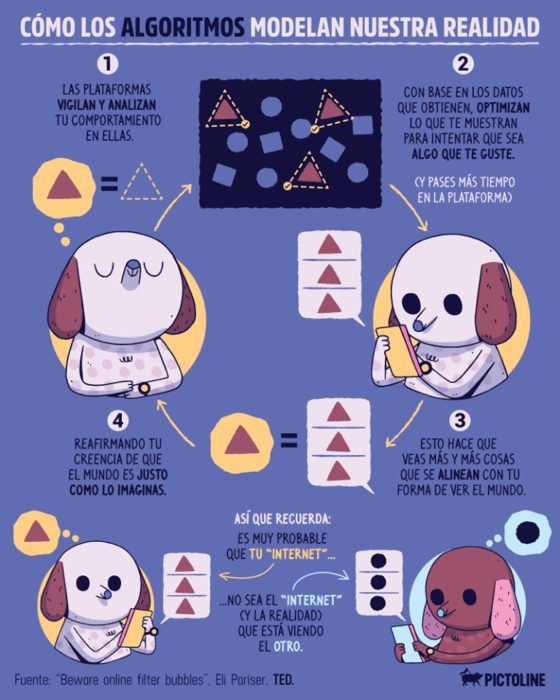

Las burbujas de filtro generan polarización de puntos de vista

Cada segundo que navegas en Facebook, estás alimentando datos en su algoritmo de filtrado. Y el resultado es una burbuja de filtro , ya que Facebook filtra el contenido que cree que no le gustará y filtra el contenido que es más probable que lea, le guste y comparta.

Eli Pariser, presidente de la organización de campaña MoveOn, fue uno de los primeros en publicitar el efecto de las burbujas de filtro en una charla Ted de 2011. Pariser notó que, aunque su lista de amigos de Facebook estaba bastante equilibrada entre conservadores y liberales, no había nada neutral en su suministro de noticias. Su tendencia a dar me gusta, compartir o hacer clic en contenido liberal estaba llevando a Facebook a darle más de lo que pensaba que quería, hasta que nunca vio ningún contenido conservador.

Como argumentó Pariser, esto es problemático. Muchas personas obtienen sus noticias e información de Facebook y piensan que están recibiendo un contenido equilibrado. Pero en realidad, los algoritmos con gran poder pero sin responsabilidades cívicas les están dando una visión sesgada del mundo.

Problemas aún peores surgen cuando los efectos de la burbuja de filtro cambian a los usuarios de vistas convencionales a vistas más extremas. Esto puede suceder como resultado de algoritmos que desplazan a los usuarios hacia contenido más emotivo e indignante.

Por ejemplo, un ex empleado de YouTube, Guillaume Chaslot, escribió un software que mostraba cómo funcionaban las recomendaciones algorítmicas de YouTube. Mostró que, si un usuario mira cualquier video en la plataforma sobre el 11 de septiembre, ese usuario recibirá recomendaciones para videos de conspiración del 11 de septiembre.

Pero incluso sin algoritmos, las personas a menudo se radicalizan en las redes sociales. Y ese es particularmente el caso cuando son miembros de grupos de Facebook. Hay innumerables grupos en Facebook y, sean cuales sean tus preferencias políticas, hay uno para ti. Y son geniales para el negocio de Facebook, ya que permiten una orientación fácil para los anunciantes.

Pero pueden ser problemáticos. Cass Sunstein, el economista del comportamiento y coautor de Nudge (2008), ha demostrado que cuando las personas con puntos de vista similares discuten temas, sus opiniones tienden a volverse más fuertes y más extremas con el tiempo.

Hay otro problema con los grupos: son vulnerables a la manipulación. La organización Data for Democracy ha demostrado que solo el uno o dos por ciento de los miembros de un grupo pueden dirigir su conversación, si saben lo que están haciendo.

Y esto es exactamente lo que hicieron los rusos antes de las elecciones estadounidenses de 2016.

Rusia usó Facebook como una forma subrepticia pero efectiva de influir en las elecciones estadounidenses.

¿Realmente sabes de dónde viene el contenido que lees en Facebook? Si estuvo en los Estados Unidos en 2016, es muy probable que haya leído, y tal vez incluso compartido, contenido de Facebook que se originó con trolls rusos.

A pesar de la creciente evidencia, Facebook negó que Rusia hubiera usado la plataforma hasta que, en septiembre de 2017, admitió que había descubierto gastos publicitarios de alrededor de $100,000 en cuentas falsas alojadas en Rusia. Facebook revelaría más tarde que la injerencia rusa había alcanzado los 126 millones de usuarios en la plataforma y otros 20 millones en Instagram. Dado que 137 millones de personas votaron en las elecciones, es difícil no creer que la interferencia rusa tuvo algún impacto.

Las tácticas de Rusia en las elecciones de 2016 fueron irritar a los partidarios de Trump, mientras deprimían la participación entre los posibles votantes demócratas.

Y la verdad es que fue fácil, gracias a los grupos de Facebook, que ofrecieron a Rusia una forma sencilla de dirigirse a grupos demográficos clave. Por ejemplo, los agentes rusos dirigieron una serie de grupos enfocados en personas de color, como el grupo Blacktivist, aparentemente con el propósito de difundir información falsa que reduciría la probabilidad de que los usuarios votaran por la demócrata Hillary Clinton.

Además, los grupos facilitaron el intercambio de contenido. Tendemos a confiar en nuestros compañeros de grupo; después de todo, comparten nuestros intereses y creencias. Por lo tanto, a menudo no criticamos de dónde proviene la información, si se comparte dentro de un grupo con el que nos identificamos.

El propio autor notó que amigos suyos compartían imágenes profundamente misóginas de Hillary Clinton que se habían originado en grupos de Facebook que apoyaban a Bernie Sanders, el oponente de Clinton en las primarias demócratas. Era casi imposible creer que la campaña de Sanders estaba detrás de ellos, pero se estaban propagando de forma viral.

Y la capacidad de Rusia para influir a través de grupos se mostró vívidamente con el notorio ejemplo de las protestas en las mezquitas de Houston en 2016, cuando eventos de Facebook controlados por rusos organizaron protestas simultáneas tanto a favor como en contra del Islam frente a una mezquita en Houston, Texas. La manipulación fue parte de los esfuerzos generales de Rusia para sembrar la discordia y la confrontación en los Estados Unidos basados en un sentimiento anti-minoría y anti-inmigrante, ya que Rusia sabía que esto le haría el juego a la campaña de Trump.

Cuatro millones de personas votaron por Obama en 2012, pero no por Clinton en 2016. ¿Cuántos de estos cuatro millones no votaron por los demócratas debido a la desinformación rusa y las mentiras sobre la campaña de Clinton?

La historia de Cambridge Analytica destapó el enfoque arrogante de Facebook con respecto a la privacidad de los datos.

En 2011, Facebook firmó un acuerdo con el organismo y regulador estadounidense de protección al consumidor, la Comisión Federal de Comercio, que prohibía a Facebook prácticas engañosas de privacidad de datos. Según el decreto, Facebook necesitaba obtener el consentimiento explícito e informado de los usuarios antes de poder compartir sus datos. Pero la triste realidad es que Facebook no hizo nada por el estilo.

En marzo de 2018, salió a la luz una historia que relacionaba el impacto político de Facebook con su desprecio por la privacidad de los usuarios. Cambridge Analytica, una empresa que proporciona análisis de datos para la campaña electoral de Donald Trump, había recolectado y malversado casi cincuenta millones de perfiles de usuarios de Facebook.

Cambridge Analytica financió a un investigador, Aleksandr Kogan, para construir un conjunto de datos de votantes estadounidenses. Creó una prueba de personalidad en Facebook, que 270.000 personas tomaron a cambio de un par de dólares. La prueba recopiló información sobre sus rasgos de personalidad.

De manera crucial, también capturó datos sobre los amigos de Facebook de los examinados, los 49 millones de ellos colectivamente, sin que estos amigos supieran nada al respecto, y mucho menos que dieran su consentimiento. De repente, el equipo de datos de un controvertido candidato presidencial tenía un tesoro de datos personales muy detallados de unos 49 millones de personas. Y aunque a Cambridge Analytica no se le permitió, según los términos de servicio de Facebook, usar los datos comercialmente, lo hizo de todos modos.

Esto fue particularmente controvertido porque, según un denunciante, Cambridge Analytica pudo hacer coincidir los perfiles de Facebook con 30 millones de archivos de votantes reales. Esto le dio a la campaña de Trump datos enormemente valiosos sobre el trece por ciento de los votantes de la nación, lo que le permitió dirigir la propaganda a estos votantes con una precisión increíble. Recuerde que solo tres estados indecisos, ganados por Trump con un margen combinado de solo 77,744 votos, le dieron una victoria en el Colegio Electoral. Parece casi imposible que la orientación de Cambridge Analytica, basada en la violación de datos de Facebook, no haya influido en este resultado.

Cuando salió a la luz la historia, Facebook trató de argumentar que había sido víctima de la negligencia de Cambridge Analytica. Pero las acciones de Facebook sugieren lo contrario. Cuando Facebook se enteró de la violación de datos, le escribió a Cambridge Analytica, solicitando que se destruyeran copias del conjunto de datos. Pero nunca se llevó a cabo ninguna auditoría o inspección. En cambio, solo se le pidió a Cambridge Analytica que marcara una casilla en un formulario para confirmar el cumplimiento. Además, Facebook felizmente había integrado a tres miembros del equipo en las operaciones digitales de la campaña de Trump al mismo tiempo que Cambridge Analytica trabajaba para Facebook.

La historia de Cambridge Analytica fue un punto de inflexión. Muchos llegaron a creer que, en la búsqueda del crecimiento y las ganancias, Facebook había ignorado sus obligaciones morales y sociales.

Si esto es cierto, queda esta pregunta: ¿Qué puede hacer la sociedad al respecto?

Facebook y otros gigantes tecnológicos deberían estar adecuadamente regulados para limitar el daño que pueden causar

Como han demostrado la injerencia rusa y los escándalos de Cambridge Analytica, Facebook no se ha tomado suficientemente en serio la necesidad de regular su propio comportamiento. Quizás, entonces, ha llegado el momento de pensar en la regulación externa.

Un aspecto de esto debería ser la regulación económica diseñada para debilitar el poder de mercado general que tienen Facebook y otros gigantes tecnológicos, al igual que el tipo de regulación aplicada en el pasado a gigantes como Microsoft e IBM. Una de las razones por las que Facebook es tan poderoso es porque ha utilizado su peso financiero simplemente para comprar competidores, como Instagram y WhatsApp.

Esto no tiene por qué influir negativamente en el crecimiento económico o en la innovación general, como muestra el ejemplo histórico del operador de telefonía AT&T. En 1956, AT&T llegó a un acuerdo con el gobierno para controlar el poder en espiral de la empresa. Se limitaría al negocio de telefonía fija y licenciaría sus patentes sin costo alguno para que otros pudieran usarlas.

Esto resultó ser una muy buena noticia para la economía de EE. UU. porque, al hacer que el invento y la patente cruciales de AT&T, el transistor, estuvieran disponibles gratuitamente, este fallo antimonopolio esencialmente dio origen a Silicon Valley. Computadoras, videojuegos, teléfonos inteligentes e Internet: todo provino del transistor.

Y lo que es más importante, el caso también funcionó para AT&T. Confinado a un negocio central, sin embargo, tuvo tanto éxito que estuvo sujeto a otro caso de monopolio en 1984. Aplicar el mismo tipo de lógica a empresas como Facebook y Google aún les permitiría prosperar, pero limitaría su poder de mercado y alentaría una mayor competencia. .

La regulación económica es una cosa. Pero si realmente vamos a abordar el impacto dañino de Facebook en la sociedad, también necesitamos una regulación que llegue al corazón de su nocividad.

Un lugar para comenzar sería exigir la opción de una vista de suministro de noticias de Facebook sin filtrar. Con solo hacer clic en un botón, puede alternar su fuente de noticias de «su vista», según los juicios de inteligencia artificial de Facebook sobre lo que lo mantendrá interesado por más tiempo, a una vista más neutral o equilibrada de lo que está sucediendo en el mundo.

Otro paso positivo sería regular los algoritmos y la inteligencia artificial. En los EE. UU., esto podría hacerse a través de un equivalente a la Administración de Drogas y Alimentos para la tecnología, con la responsabilidad de garantizar que los algoritmos sirvan, en lugar de explotar, a los humanos. La auditoría de algoritmos por parte de terceros crearía suficiente transparencia para evitar los peores casos de burbujas de filtro y manipulación.

Aceptamos y valoramos la regulación en muchas industrias, utilizándola para lograr el equilibrio adecuado entre el interés público y la libertad económica. En la actualidad, cuando se trata de tecnología, ese equilibrio no se logra correctamente. Es tiempo de cambiar.

Cambie la apariencia física de sus dispositivos para reducir su impacto en su salud. Dos cambios en la apariencia de sus dispositivos digitales pueden marcar una gran diferencia. Primero, cambiar su dispositivo al modo de turno de noche reducirá el azul en la pantalla, lo que reduce la fatiga visual y hace que sea más fácil conciliar el sueño. En segundo lugar, poner un teléfono inteligente en modo monocromático reduce su intensidad visual y, por lo tanto, el golpe de dopamina que obtienes al mirarlo.